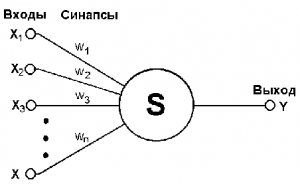

модель роботи нейрона [1]

На вхід подається вектор імпульсів xn, що складається з n числових ознак. Усередині нейрона імпульси складаються з деякими вагами wj. j = 1..n і, якщо сумарний імпульс S (x) = ^ n "/> перевищить поріг актівацііw0. то нейрон збуджується і видає деяке значення a (x) = S (x) - w0.

Якщо додати фіктивний імпульс-ознака x0 ≡ -1 і йому зіставити вагу w0 - поріг активації, то формулу виходу Y (x) можна виписати більш компактно:

a (x) = (w, x). де (w, x) - скалярний твір, w і x - вектори ваг і імпульсів-ознак відповідно.

навчання ADALINE

Нехай дана навчальна вибірка: безліч вхідних значень X і безліч виходять значень Y. такі що кожному входу xj відповідає yj - вихід, j = 1..m. Необхідно за цими даними побудувати ADALINE, яка допускає найменшу кількість помилок на цій навчальній вибірці. Навчання ADALINE полягає в підборі "найкращих" значень вектора ваг w. Які значення ваг краще визначає функціонал втрат .У ADALINE використовується функціонал, запропонований Відроу і Хоффом, L (a, x) = (a - y) 2. Таким чином необхідно мінімізувати функціонал Q (w).

Застосуємо метод градієнтного спуску. тоді таке значення матиме вигляд:, де - темп навчання.

Схема навчання ADALINE

- - навчальна вибірка з m елементів

- - темп навчання

- - параметр згладжування функціоналу

- Ініціалізувати ваги;

- Ініціалізувати початкову оцінку функціоналу:;

- повторювати:

- Вибрати об'єкт з (наприклад, випадковим чином);

- Обчислити помилку:;

- Зробити крок градієнтного спуску:;

- Оцінити значення функціоналу:;

- Поки значення не стабілізується і / або ваги не перестануть змінюватися.

Зв'язок навчання ADALINE з Stochastic Gradient

Схема навчання ADALINE відповідає схемі навчання лінійного класифікатора методом стохастичного градієнта c лінійною функцією активації φ (z) = z і квадратичною функцією втрат L (a, x) = (a - y) 2.