Функція дозволяє збільшити розмір поля для даних в пакеті IP. Виходить, що ми тим же числом пакетів (тобто з тими ж накладними витратами) передаємо більше корисної інформації. Якщо в стандартному IP-пакеті поле для даних має розмір 1500 байт, то при використанні Jumbo Frame - до 9000 байт.

повинні підтримуватися всіма вузлами мережі, тобто повинні бути включені на фізичних комутаторах, віртуальних комутаторах або розподілених вКоммутаторах, а також у фізичних і віртуальних серверах. Jumbo Frames можуть використовуватися з мережевими контролерами 1 Гбіт і 10 Гбіт.

Jumbo Frames можуть використовуватися віртуальними машинами і портами VMkernel для трафіку NFS, iSCSI і vMotion. Для початку використання нам необхідно включити їх підтримку на фізичних комутаторах, потім для vSwitch і dvSwitch, а далі налаштувати їх використання всередині ВМ або для віртуального контролера VMkernel.

Найпростіше включити їх використання для розподіленого комутатора: Home. Networking. в контекстному меню dvSwitch пункт Edit Settings. Advanced. Maximum MTU. Вказуємо розмір поля для даних. Найчастіше ис

користується максимальний - 9000.

Для стандартних комутаторів VMware включення Jumbo Frames робиться в два етапи.

Спочатку підключіться за допомогою ssh або vSphere CLI до сервера ESX (i).

esxcfg-vswitch -m

Подивитися поточні настройки можна командою

Отже, перший крок - включення підтримки на віртуальних комутаторах - ви зробили. Крок номер два - включити цю функцію на ВМ і / або на інтерфейсах VMkernel.

Мал. 2.35. Налаштування драйвера vmxnet3

Для перевірки роботи відправте великий пакет сусідній ВМ:

На виході повинно вийти щось на зразок:

ping

і VMkernel

Для використання Jumbo Frames з інтерфейсами VMkernel необхідно включити цю функцію на них. виконайте команду

З'явиться список існуючих інтерфейсів VMkernel. Якщо в стовпці MTU варто значення 1500, значить, не використовується. На жаль-

нію, змінити цю настройку для вже існуючого інтерфейсу можна, можна тільки його перебудувати. Для цього видаліть існуючий інтерфейс, для якого хочете включити. Коли видаляється інтерфейс підключений до стандартного віртуального комутатора, синтаксис команди наступний:

esxcfg-vmknic -d <название группы портов, куда подключен удаляемый интерфейс>

Потім створіть новий командою

esxcfg-vmknic -a -i

Зауваження з приводу синтаксису вищенаведених команд: у кожного інтерфейсу VMkernel є власне ім'я виду vmk #. Кожен такий інтерфейс числиться підключеним до групи портів. При виконанні вищенаведених команд під <название группы портов, куда подключен удаляемый интерфейс> розуміється як раз назва групи портів, а не інтерфейсу.

Зверніть вніманіе.нельзя включити на ESXi з безкоштовною ліцензією.

Ті команди з видалення і створення інтерфейсу VMkernel, що були показані вище, дані в варіанті для стандартних вКоммутаторов. У разі використання розподілених вКоммутаторов є невеликий нюанс.

У актуальною на момент написання версії vSphere CLI не виявилося способу створити інтерфейс VMkernel на розподіленому віртуальному комутаторі. Тому слід вчинити так.

1. Створити інтерфейс VMkernel з MTU = 9000 якомусь стандартному віртуальному комутаторі описаним вище способом.

2. Перенести цей інтерфейс на розподілений віртуальний комутатор.

Для цього пройдіть Configuration. Networking. кнопка Distributed

virtual adapter.

має сенс використовувати для інтерфейсів VMkernel, задіяних під будь-які завдання. Єдиний виняток - трафік управління ESXi.

2.4.5. TSO - TCP Segmentation Offload, або TOE - TCP offload engine

TOE (TCP offload engine) - функція фізичного мережевого контролера, коли частина роботи по обробці стека TCP / IP, така як формування і підрахунок контрольної суми пакетів, які виконують не службою в ОС, а самим контрол-

Лером. Частина цього механізму - TSO, TCP Segmentation Offload, функція також відома як «large segment offload», або LSO. TSO дозволяє обробляти великі пакети (до 64 Кб) при будь-якому розмірі MTU, формуючи з великого пакета більшу кількість пакетів меншого розміру.

У документації VMware зазвичай вживається термін TSO, інші назви приведені для довідки.

Включення цієї функції дозволяє знизити навантаження на процесори сервера і підвищити швидкість роботи мережі. Помітна різниця в навантаженні на процесори сервера буде, швидше за все, лише в інфраструктурах зі значним мережевим трафіком.

Формально ми можемо задіяти цю функцію для трафіку ВМ і VMker nel. «Формально» - тому, що мені зустрічалися твердження інженерів VMware, що в vSphere (в перших версіях, по крайней мере) мережеві контролери з TSO працюють, але для трафіку ВМ TSO не використовується, так як внутрішні тести не показали значущою ефективності на різноманітних завданнях (див. http://communities.vmware.com/thread/217825). Для трафіку ВМ цю функцію можна задіяти, прокинув фізичний мережевий контролер в ВМ за допомогою функції VMDirectPath.

Може знадобитися включення TSO в BIOS мережного контролера. Зверни ті увагу, що якщо контролер з підтримкою TSO значиться в списку сумісності ESX (i), то це означає, що ESX (i) запрацює з цим мережевим контролером, але не гарантує роботу з його функціями TSO. Якщо вас цікавить саме функціонал TSO, то сумісність контролера з ESX (i) потрібно перевіряти саме з упором на TSO (по документації до мережевого контролеру).

Для інтерфейсів VMkernel TSO включений за замовчуванням. Перевірити це можна, виконавши команду

Якщо в стовпці TSO MSS значення 65535, то TSO включений. Якщо він вимкнений, то єдиний спосіб його включити - перебудувати інтерфейс заново (як це зробити, описано в розділі про).

Вимкнути використання TSO для ESX (i) можна через розширені настройки. Пройдіть в настройки сервера: Configuration. Advanced Settings для Software. налаштування UseHwTSO вам потрібно присвоїти значення нуль.

Швидше за все, виключення може знадобитися лише в разі проблем з використанням цієї функції з вашими мережевими контролерами. У разі проблем перед відключенням TSO відновите прошивку контролера і ESX (i) (або окремо драйвер для контролера).

2.4.6. VMDirectPath

Функція VMDirectPath дозволяє виділяти в приватне користування ВМ контролер в слоті PCI сервера. Таким контролером може бути мережева карта. Подробиці див. В розділі про компоненти ВМ.

2.4.7. Окремі порти

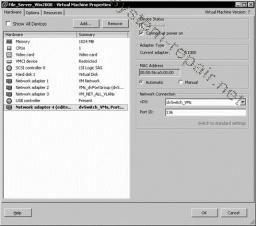

На розподіленому віртуальному комутаторі віртуальні машини підключаються до груп портів і до портів з конкретним номером. Наприклад, у властивостях ВМ ви можете побачити можливість підключення віртуального мережевого контролера до конкретного порту - рис. 2.36.

Мал. 2.36. Налаштування мережевого підключення ВМ до окремого порту dvSwitch

Це може бути важливо з тієї причини, що для розподілених віртуальних комутаторів змінювати налаштування (такі як VLAN, traffic shaping, security і ін.) Можна і для окремого порту.