Схожі (дубльовані) сторінки. Як виявити дублі контенту

Нижче ми розглянемо кілька найпоширеніших варіантів дублювання контенту, а зараз давайте поговоримо про те, як впливають подібні сторінки на просування сайту.

Пошукові системи давно навчилися визначати унікальність тексту по послідовності символів, тобто по однаково складеним пропозицій, звідки береться послідовність літер і пробілів. Якщо контент не рідкість (крадений), то робот без праці це з'ясує, а коли не рідкість текст зустрічається часто, то перспектива потрапляння такого ресурсу під фільтр АГС досить висока.

Давайте уявимо собі роботу пошукового робота. Зайшовши на сайт він в першу чергу дивиться на файл robots.txt і від нього отримує інструкції: що потрібно індексувати і що для індексації закрито. Наступним його дією буде звернення до файлу sitemap.xml, який покаже роботу карту сайту з усім дозволеними маршрутами. Почитайте статтю - «Файл sitemap.xml для пошукових систем Google і Яндекс.» Отримавши всю необхідну інформацію, робот відправляється виконувати свої звичні функції.

Припустимо, сторінка має високу унікальність і робот її проіндексував, але пройшовши за наступним URL того ж ресурсу він потрапляє на сторінку з повністю або частково схожим текстом. Як в такій ситуації надійде пошуковик? Звичайно він теж не стане індексувати схожий тест, навіть якщо оригінал перебувати на тому ж сайті, але по іншому URL. Робот напевно залишиться незадоволений марно витраченим часом і обов'язково зробить пометочкі в своєму блокноті. Знову ж таки, якщо такий інцидент буде неодноразово повторюватися, то ресурс може впасти в немилість до пошукової системи.

Висновок №1. Схожі сторінки розташовані по різними URL забирають час, який відводиться роботу для індексації сайту. Дублі сторінок він все одно індексувати не буде, але витратить частину часового ліміту на ознайомлення з ними і може не вистачити часу дістатися до дійсно унікального контенту.

Вивод№ 2. Дубльований контент негативно позначиться але просуванні сайту в пошуковій системі. Не люблять пошукачі не унікальні тексти!

Висновок №3. Треба обов'язково перевіряти свій проект на дублі сторінок, щоб уникнути проблем перерахованих вище.

Багато абсолютно не піклуються про «чистоту» свого контенту. Заради інтересу я перевірив кілька сайтів і був дещо здивований стану справ з дублями сторінок. На блозі однієї жінки я взагалі не виявив файлу robots.txt.

Необхідно з усією серйозність боротися з дублями контенту і починати треба з їх виявлення.

Приклади часто зустрічаються дублів контенту і способи усунення проблеми

Дубль головної сторінки. приклад:

У цьому випадки питання вирішується за допомогою 301 редіректу - «командою» для сервера через файл .htaccess. Як зробити 301 редирект (перенаправлення) через файл .htaccess

Ще один приклад дубля головної сторінки:

Щоб уникнути подібного дублювання можна прописати основне дзеркало сайту в файлі robots.txt в директиві - «Host» для Яндекс:

А також скористатися 301 перенаправленням і вказати пошуковим системам Яндекс і Google на головне дзеркало сайту за допомогою інструментів для веб-майстрів.

Приклад дубля головної сторінки, який мало не підірвав мені мозок при пошуку рішення виглядає так:

Я десь прочитав, що слеш в кінці посилання на головну сторінку, створює дубль і пошуковики сприймають посилання зі Слеш і без, як різні URL, що ведуть на сторінку з однаковим текстом. Мене занепокоїла навіть не сама можливість дублювання, скільки втрата ваги головної сторінки в такій ситуації.

Я почав копати. За запитом до сервера з вищезазначених URL я отримав відповідь код 200. Код 200 означає - "Запит користувача оброблений успішно і відповідь сервера містить викликані дані». З цього випливає, що все-таки дубль на обличчя.

Я навіть спробував зробити 301 редирект (перенаправлення), але команди не діяли, і бажаного відповідного коду 301 я так і отримав. Рішення проблеми полягала у відсутності самої проблеми. Каламбур такий вийшов. Виявляється, сучасні браузери самі підставляють символ «/» в кінці рядка, роблячи його невидимим, що автоматично робить дубль неможливим. Ось так!

Ну і ще один приклад дубля головної сторінки:

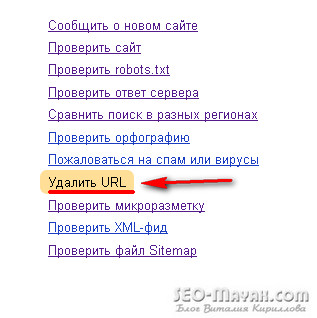

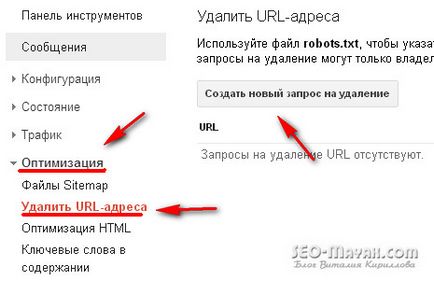

У пошуковій системі Яндекс, веб- майстер - мої сайти - видалити URL:

і в файлі .htaccess прописати 301 редирект.

Тепер пройдемося по дублям зустрічається при неправильному складанні файлу robots.txt. приклад:

На перший погляд не чого особливого, але це і є класичний приклад часткового дублювання.

Що таке часткове дублювання? Це коли в індекс потрапляють сторінки з анонсами постів. Причому розмір таких анонсів бувають мало не в половину всієї статті. Не робіть об'ємних анонсів! Рішення проблеми просте. У файлі robots.txt прописуємо наступне:

Приклад повного дублювання:

Рішення знову ж перебувати в файлі robots.txt

Я не веду мову про інтернет магазини та інші сайти на комерційній основі, там ситуація інша. Сторінки з товарами, що містять частково повторюється текст з безліччю зображень, також створюють дублі, хоча візуально виглядає все нормально. У таких випадках в основному застосовується спеціальний тег:

Важливо! Директиви, прописані у файлі robots.txt, забороняють пошуковим роботам сканувати текст, що вберігає сайт від дублів, але ті ж директиви не забороняють індексувати URL сторінок.

Як визначити подібні сторінки за фрагментом тексту

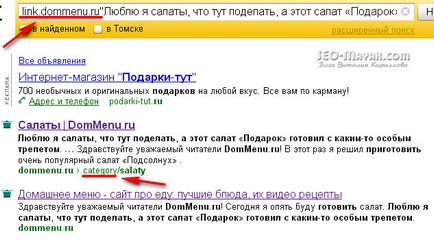

Є ще один досить дієвий спосіб визначення «клонів» за допомогою самих пошукових систем. В Яндексі в поле пошуку треба вбити: link.сайт.com «Фрагмент тесту». приклад:

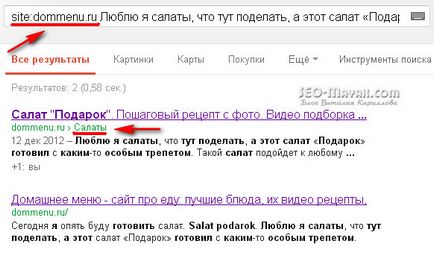

За допомогою пошуку Google перевірити можна так: site: сайт.com «Фрагмент тексту». приклад:

Програми та онлайн сервіси для пошуку внутрішніх і зовнішніх дублів контенту за фрагментами тексту

Я не буду в цій статті робити детальний огляд популярних програм і сервісів, зупинюся лише на тих, якими сам постійно користуюся.

Для пошуку внутрішніх і зовнішніх дублів раджу використовувати онлайн сервіс www.miratools.ru. Крім перевірки тексту сервіс включає ще різні цікаві можливості.

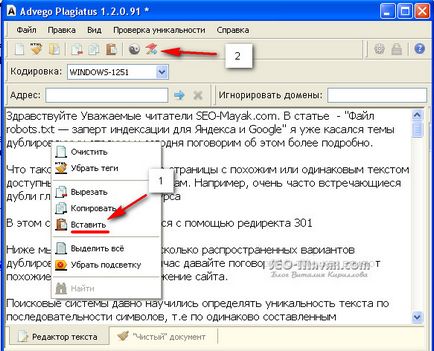

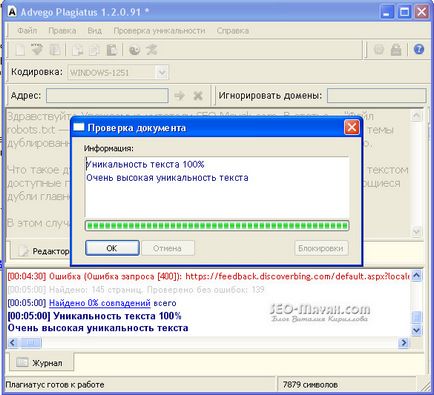

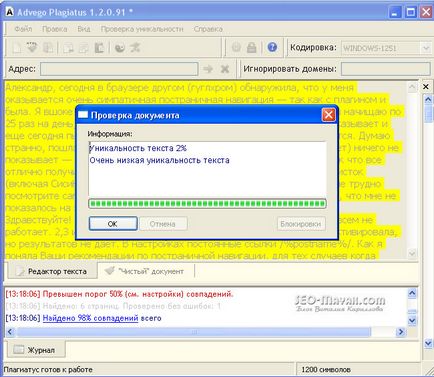

Програма для пошуку дублів - Advego Plagiatus. Дуже популярна програма, особисто я їй користуюся постійно. Функціонал програми простий, щоб перевірити текст достатньо скопіювати його і вставити у вікно програми і натиснути на старт.

Також, будуть виділені жовтим фоном конкретні фрагменти тексту, за якими програми знайшла збіги:

Дуже хороша програма, користуйтеся і обов'язково підпишіться на оновлення блогу.

На сьогодні у мене все. Успіхів!

З повагою, Кирилов Віталій

Добридень! Випадково потрапив на Ваш сайт і .... панеслась. Хоча він у Вас ще й молодий, але багато корисного я для себе знайшов!

Перше що хочу запитати. Потрібно однаково прописувати в Роботс як для User-agent: Yandex так і для User-agent: *.

І чи потрібно мені прописувати

Disallow: / tag /

Disallow: / * page *

Disallow: / page /

Disallow: / 20 *

Disallow: / category /

Дякую за розуміння і чекаю відповідь. Був би вдячний допомоги.

Юрій, радий вітати Вас на своєму блозі! Так, треба однаково прописувати все крім директиви Host, вона призначається тільки для Яндекса. Юрій, поясню по-порядку. Треба закрити теги «Disallow: / tag /» щоб не створювати дублі, те ж саме стосується і:

Disallow: / * page *

Disallow: / page /

Disallow: / 20 *

Disallow: / category /

Але краще скористайтеся сервісом Яндекс Вебмайстер і подивіться чи немає в пошуку дублів або неканонічних (однакових) сторінок.

Успіхів!

Віталій, Ви такий молодець! З великим інтересом вважаю Ваші статті.

Віталій, питання з приводу дубляжу сторінок сайту.

У мене і-нет маг. Якщо у мене є 10 продуктів одного найменування, що відрізняються тільки розміром, як бути з описом товару, невже на все 10 штук писати різний опис?

Валентина, тут треба дивитися індивідуально. Звичайно краще для Вас, щоб не було дублів, але якщо товар однаковий може краще вибрати одну сторінку для пошуку, а решта закрити тегом rel = "canonical».

Доброго дня, Тетяно!

Ви все правильно зробили, але можна ще в файлі robots.txt приписати таку директиву:

[Php] Disallow: / category / [/ php]

Привіт, Віталій! Дякую за пізнавальні статью.На сторінці веб-майстра в Яндексі побачив, що багато моїх сторінки не індексуються, хоча коли там же в вебмайстрів перевіряєш сторінку, то система видає відповідь, що вона дозволена для індексаціі.Как мені це розуміти? Чи треба мені в свій robot.txt додати ці рядки: Disallow: / page /

Disallow: / 20 *

Disallow: / category /

Дякуємо

Привіт Анна! Намагайтеся переставляти слова і міняти пропозиції, щоб домогтися високої унікальності. Advego Plagiatus шукає не тільки на інших сайтах, але і на Вашому теж і тому можуть збігатися різні регулярні вирази, які властиві кожній веб-майстру, а це непогано може псувати унікальність.

Перевіряйте все, але унікальність повинна бути висока!

Привіт, Віталій! У мене великі проблеми з сайтом. Чомусь індексується дуже багато копій однієї і тієї ж статті на моєму сайті (більше 20). Головне, чим далі, тим копій стає більше, при менш 100 написаних постів в індексі у Яндекса їх вже 3000. Допоможіть, будь ласка! Що може бути не так на сайті? Чому копій так багато? Такі неприємності почали відбуватися після поновлення плагіна All In One SEO Pack. Я почитала Вашу статтю по темі настройки плагіна - там все в порядку. В Яндекс Вебмайстер я завантажила robots.txt. Він мені видав відповідь, але я в ньому нічогісінько не зрозуміла.

буду дуже вдячна за відповідь!

Добридень, Ольго! По-перше у вас не закриті від індексації посторінкова навігація і теги, можливо і ще що-небудь. Мені важко відразу сказати, що стало причиною появи таких посилань, як ця - sosna-gornaya-ukrashenie-sada / 9223372036854775804 /, але треба обов'язково розібратися. Стати передплатником блогу і напишіть мені через форму зворотного зв'язку. І ми з Вами поспілкуємося!

Марія, у мене після апдейтів Яндекса блог не раз втрачав позиції. Думаю це пов'язано з обнуленням якихось факторів, так як через пару тижнів всі мої «скривджені» статті поверталися на колишні позиції і відвідуваність відновлювалася. Напевно є сенс почекати, а якщо за два тижні нічого не зміниться, тоді бити тривоги. Повірте сайт на зовнішні дублі і проаналізуйте настройки індексації сайту. Подивіться скільки робот Яндекса завантажив сторінок, а скільки потрапило в пошук, і чи є серед виключених, неканонічні сторінки.

Спасибі, Віталій, я перевірю, напишу.

ТОлько сьогодні здивувалася ще тому, що при попвтке додати нову статтю в аддурл яндекса.

Він мені видав:

Недоступний сервер, на якому знаходиться сайт.

Хоча сайт онлайн. Теж саме і гугл пошуком звідти вилетіли всі сторінки

Привіт Рита! Про настоянці індексації сайту я написав кілька статей.

Мета-тег robots - дуже раджу почитати.

Supplemental index

Якщо будуть питання, задавайте.

Привіт, Віталій!

Мене давно мучить питання чи потрібно відкривати для індексації архіви, якщо я періодично переробляю старі статті. На даний відповідь підтримка Яндекса відповіла так: «Якщо такі сторінки повинні індексуватися і брати участь в пошуку, заборона з їх вихідного коду необхідно прибрати. »

Я не зовсім зрозуміла це відповідь. А питання було таке: «Я навмисно заборонила до індексації старі архіви, але чи правильно це, якщо я вношу зміни в старі статті?»

Сподіваюся, що мені допоможете! Дякуємо!

Тетяна

Доброго дня, Тетяно!

Якщо сторінка заборонена від індексації, то зміни також не індексуватися.

Тетяна, зміна або доповнення будь-якої сторінки ніколи не каралося, адже це природний процес. Інша справа на скільки ці зміни істотні, можливо повністю зміниться тест або ще будуть якісь серйозні правки. У такому випадки я утруднений Вам дати слушну пораду.