Привіт шановні читачі блогу PomKomp.ru Правильний файл robots.txt запорука успішного просування і швидкої індексації сайту пошуковими системами. Він був розроблений досить давно і використовується до цих пір.

Основні завдання robots.txt:

1. Забороняє або дозволяє індексувати каталоги, сторінки, файли і їх групи.

2. Вказувати файл з картою сайту (sitemap.xml).

3. Вказувати головне дзеркало (якщо є).

Перед тим як почати опис всіх дій раджу звернути увагу на файл мого сайту. Для цього достатньо до URL додати /robots.txt

Файл Роботс потрібен всім сайтам, незалежно від того великий він чи маленький, інтернет-магазин або просто одностанічнік. Навіщо пошукачам файл Роботс? Справа в тому, що пошукова система індексує всі документи, які зберігаються на вашому домені, а це картинки, таблиці стилів, скрипти і так далі. Це все ускладнює процес індексації сайту роботу і збільшує час, який він витрачає на ваш проект. Для того щоб сказати роботу що можна індексувати, а що ні, служить файл robots.txt.

Як ви помітили, Роботс має розширення .txt, а значить створити його можна в звичайному блокноті у себе на ПК, а потім залити на хостинг. Пам'ятайте, що в назві повинні бути тільки літери нижнього регістру.

Правильний роботс.txt складається з директив і їх властивостей (параметрів). Їх всіх ми розглянемо в міру написання файлу. Найперша директива яка стоїть спочатку це User-agent. Вона показує для якого робота написані подальші параметри.

Властивості директив прописуються через двокрапку і пробіл. В наведеному вище прикладі ми вказали директиві User-agent параметр «*», який говорить, що прописані далі властивості всі пошукові роботи будуть сприймати однаково. Якщо потрібно дозволити індексувати сайт певного роботу, після двокрапки потрібно прописати його назву.

Потрібно відзначити, що в параметрах директиви User-agent вказується тільки один пошуковий робот, а значить запис виду

Буде неправильна.

Allow / Disallow.

З назви цих директив ясно, що allow дозволяє боту індексувати файл, сторінку, каталог і їх групи, а disallow забороняє. За замовчуванням всі каталоги відкриті для індексації, тому сама по собі директива allow сенсу не несе, її потрібно використовувати разом з забороняє директивою disallow.

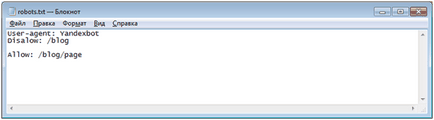

Приклад використання директив Allow / Disallow:

Тут ми заборонили головному пошуковому боту Яндекс індексувати сторінки, що знаходяться в директорії blog і дозволили індексувати сторінки в каталозі / blog / page. Як ви помітили, цей файл має структуру, тобто спочатку забороняється весь каталог, а потім його частини. Такий файл краще сприймається роботами, а значить сайт пройде індексацію швидше.

Також неправильно буде писати директиви через порожній рядок. Приклад неправильної записи:

В цьому випадку сторінка / blog / page буде проіндексована.

Також директива Disallow допускає використання символів * і $.

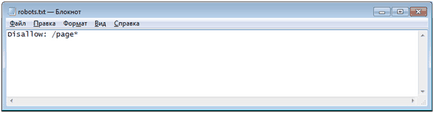

* Показує, що замість неї може стояти будь-яке значення. Таким чином записи

Задовольняють запити "Disallow / page1 /; Disallow / page2 /; Disallow / page1 / zakaz /; "і так далі, а значить все похідні від / page каталоги проіндексовані не будуть.

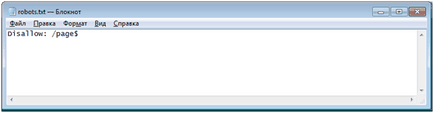

$ Вказує на точне заборона даного параметра. Так, запис

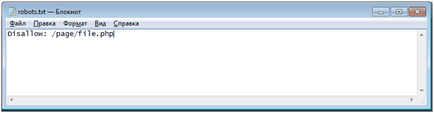

Для заборони індексації файлу потрібно прописати повний шлях до нього. Заборонимо індексувати файл file.php в каталозі / page. Для цього пишемо

"Disallow: file * .php"

Правильно писати

"Disallow: * .php"

Таким чином ми забороняємо індексувати ВСЕ файли з розширенням .php.