Файл robots.txt це початковий, і один з найголовніших інструментів для коректної індексації ваших сайтів і їх контенту. Відсутність даного файлу призведе до сумних наслідків які важко буде виправити. Від того як ви налаштуєте robots.txt залежить що потрапить в видачу по запитах в пошукових системах. Зараз розглянемо правильний файл robots.txt для WordPress сайту.

Навігація по сторінці:

Для чого використовувати robots.txt?

Перед тим як приступати до створення і наповнення давайте розберемо саму суть даного файлу.

Ваш сайт це набір файлів і папок, деякі з яких потрібно захистити від читання від сторонніх очей, якими є так само і пошукові роботи, які прийшли прочитати і запам'ятати наш контент, для подальшої видачі в пошуку.

Чим займається пошукової робот на сайті?

Отже, наприклад ваш сайт відвідав пошукової робот, що він робить в першу чергу? По-перше намагається знайти унікальну інформацію, яку зможе занести в свою базу даних. Якщо Роботс відсутня, а саме до нього в першу чергу звертається робот, тоді він починає «читати» файли знаходяться в корені сайту, що звичайно ж нам не дуже сподобатися, адже він не тільки не знайде там потрібну йому інформацію, а й прочитає наші дані налаштувань, які створені для нашої особистої мети. Саме для цього і існує robots.txt. Він дає вказівки роботу куди ходити потрібно, а куди заглядати не варто.

Створення і розміщення файлу на сайті WordPress.

Для того що б створити путівник для роботів, вам буде потрібно звичайний блокнот windows, в якому ви будете прописувати потрібні команди для пошукових роботів. Після цього потрібно зберегти файл у форматі «txt», під назвою «robots». На цьому створення завершено, далі в статті ми розглянемо які ж команди повинні знаходитися в robots.txt для WordPress.

Де розміщувати?

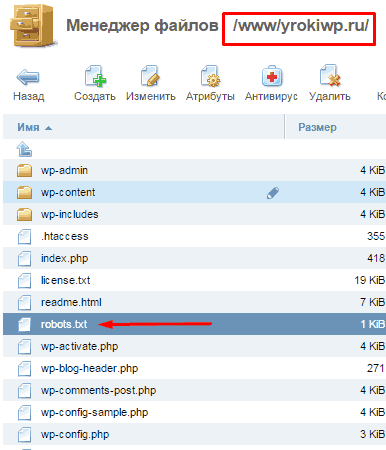

Robots.txt розміщується на вашому хостингу, безпосередньо в кореневій папці сайту, куди ми перенесли наш сайт. Тепер пошукової робот перед тим як лазити по нашому сайту, спочатку запитає дозвіл куди йому можна, а куди заборонено заходити.

Важливо: при розміщенні документа в підкаталогах, роботи не зможуть знайти цей файл.

Зайшовши до вас на сайт робот заходить дивиться призначену для нього «інструкцію» і починає його вивчати. Вивчивши до кінця він піде за обраним вами шляху індексації, і буде ігнорувати ті директорії, папки і URL до яких ви заборонили звертатися.

Що включає в себе Роботс?

Robots.txt несе в собі інформативні дані для пошукових роботів і включає в себе такі основні «команди»:

Вказує на ім'я потенційного робота відвідувача. Синтаксис «User-agent: *» означатиме що даними командам повинні слідувати всі роботи. Варіанти для окремих роботів розглядати не будемо, їх дуже багато. З цього для прикладу буде тільки два варіанти (для всіх роботів і окремо для Яндекс).

Дана команда вказує роботу, який з варіантів сайту буде нашим головним дзеркалом сайту.

Місце знаходження xml карти сайту по якій повинен пробігтися відвідав нас робот, в тій частині за якою він прийшов (контент сайту).

Для того що б правильно налаштувати файл robots.txt спеціально під «движок» WordPress потрібно для початку розуміти що шукають роботи і що їм буде цікаво.

А наші павучки шукають контент нашого ресурсу, і їм зовсім не потрібно знати про всіх інших конфігураційних даних наших сайтів. По-перше вони їм припадають до смаку, і від переїдання таких вони можуть покинути наш сайт так і не знайшовши то що нам би хотілося та ще й винесуть наші заборонені для загального очі дані на загальний огляд.

Зараз я покажу готовий варіант. Потім розберемо кожну строчку в розширеному описі. Отже, правильний robots.txt для WordPress повинен виглядати так:

Тепер подивимося як ми змогли добитися такого короткого змісту файлу robots.txt для WordPress, розглянемо розширену версію файлу і поступово приберемо повтори:

Зазначений вище приклад заблокує від індексації всі непотрібні для пошукової оптимізації файли і посилання і вкаже на той матеріал який повинен бути проіндексований.

Ну вже дуже довгий у нас вийшов приклад, зараз ми його будемо спрощувати. Для початку візьмемося за файли і папки з префіксом «wp-« їх все можна об'єднати воєдино.

Значно зменшили, але це не межа, підемо трошки далі і спробуємо ще скоротити, та ще й виконати необхідні внутрішні настройки.

Вся справа в тому що при такому варіанті файлу, Google все одно внесе заборонені вами сторінки в індекс, але виглядати вони будуть інакше:

Це не настільки небезпечно як відкриті дублі, але все ж краще від цього позбавлятися. Для того що б виправити цю ситуацію можна скористатися відразу декількома методами. Я розповім про найшвидше і найпростіше - заборона індексування сторінок за допомогою Google Webmasters Tools «Параметри URL». До речі в рекомендаціях для Яндекса краще залишити параметр «feed» в зазначеному варіанті.

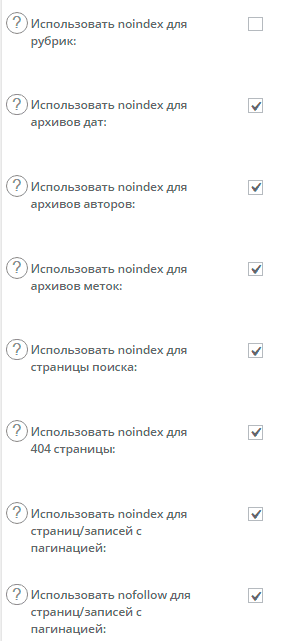

Позбулися feed за допомогою Google, тепер для альтернативи заборонимо індексування пагінацію за допомогою плагіна, який швидше за все використовується вами, якщо ж це не так, тоді альтернативний так само підійде. Йдеться про All in One SEO і його налаштуваннях тегів «robots» і «canonical».

Для того що б заборонити індексувати пошуковим системам непотрібні нам сторінки, такі як сторінки пагінацію всіх видів (головною, рубрик і міток) потрібно всього лише поставити галочки в потрібних місцях.

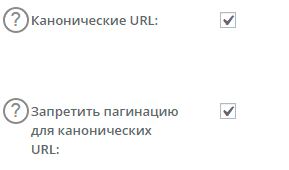

Спершу включимо канонічні посилання на головні сторінки, для уникнення їх дублювання.

Що ми зробили? Загалом все що було потрібно, ми вказали на сторінках які дублюють наш контент посилання на основну сторінку, що вкаже роботу що саме потрібно сканувати і вважати за основний контент. Тепер додамо ще мета тег robots.

Після проведених налаштувань, знову звертаємося до нашого варіанту файлу і дивимося що вийшло:

Якщо тема, яку ви встановили використовує картинки, тоді краще відкрити їх для індексу:

Allow: / wp-content / themes / назва вашої теми / images

Якщо ви проігноруєте це, у вас можуть виникнути проблеми з пошуковиками, вони не люблять коли від них приховують важливу інформацію.

Приклад можна розширювати, наприклад додаванням заборони для індексації певних посилань на сторінки, зазвичай це сторінки повтори які шкодять нашій оптимізації.

У документі зазвичай не вказують конкретно для всіх пошукових роботів окремо, а роблю два набору команд один для всіх другий для Яндекса.

Google рекомендує відкривати всі скрипти і файли стилів для індексації, це не моє перевагу, а рекомендація пошукової системи. Сьогодні гугл боти повинні бачити сайт так само як і користувачі, з цього закриваючи індексацію скриптів отримаєте попередження при перевірці сайту в вебмайстрів Гугл (Подивитись як гуглбот). Інша справа закривати від індексації посилання скриптів в ноіндекс і нофолов, але це зовсім інша історія)

Відносно файлів інсталов. Файл Роботс призначений для того, що б показати ботів де контент, а де серверні технічні дані, з цього все що не несе інформаційного навантаження має бути закрита.

Дякую за роз'яснення! Все зрозуміло. Буквально зараз зіткнулася з ще однією задачкою ...

При введенні логіна в контрол панель (я на хостагаторе) мого хостингу, чомусь просить двва рази ввести пароль. Причому пише що перший раз ви успішно вишлі.Хотя я вийшла з панелі.Странно якось ... Потім зайшовши в адмінку побачила якийсь лівий айпі під моїм логіном.Пробіла по блак листу ВИЯВИЛОСЯ, що цей айпі знаходиться в чорному списку через спаму. І це не мій айпі.Как Ви думаєте, хтось вже заліз на мій хостинг? Може ви стикалися з подібним? Є каке поради з приводу? Буду дуже вдячна за пораду

Думаю вже залізли на сайт, на хостинг менш імовірно, хоча можливо. Якщо був вхід під вашим логіном тоді потрібно оперативно змінити пароль, а ще краще і логін (видалити старий створити новий). З приводу подвійного залогініванія, то такий підхід існує але якщо він виник сам по собі, що звичайно ж не реально тоді над сайтом вже «попрацювали». Тут особливих рекомендацій не дам, потрібно перевіряти всі і не відкладаючи.

С ув. Олег

P / s Я - «я чайник» ...

Хіба Disallow: / *? * Не включає в себе Disallow: /? S = *?

відповів вам на пошту) включає, але при деяких ситуаціях потрібно використовувати тільки друге, так як перше може нашкодити індексації деяких сторінок, це вкрай рідко, але знати це потрібно

Навіщо потрібні три правила?

Disallow: / trackback

Disallow: * / trackback

Disallow: * / * / trackback

Хіба мало одного?

Disallow: * / trackback

Добрий день. Підкажіть будь ласка відповідь на наступне питання. У мене сайт новий, статті ще не випускалися. префікс бази даних я поміняв за допомогою плагіна All In One WP Security Firewall. Оскільки сайт ( «нульовий») то сама зміна пройшла безболісно.

Питання в наступному. Який префікс прописувати при складання файлу Robots.txt коли вказується директива Disallow (wp_ або вже новий змінений). Якщо новий, тоді виникає питання (заздалегідь вибачте за можливу некоректність формулювання) - в чому тоді його секретність, якщо подивитися його зможе будь-хто, дописавши в браузерної рядку після слеша robots.txt

Дякуємо.

З повагою.

База даних і файл Роботс між собою не пов'язані. Файл Роботс можна подивитися на будь-якому сайті, він не секретний, він служить путівником і правилом для правильної індексації СТОРІНОК сайту. У Роботс так само і остається все як і раніше wp-admin ... і т.д.

Дякую за консультацію.