Якщо ви користуєтеся RDS-баром, то завжди можете визначити, який відсоток індексованих сторінок сайту потрапив в цю пошукову систему:

Ці 52%, зазначені стрілкою - основний індекс. Все що не входить - «соплі».

- Допущені до участі в веб-пошуку на загальних підставах ( "хороші" сторінки »)

- Вміщені в те, що називають соплями ( "погані" сторінки »)

- "Опущені" Гуглом, які не індексуються зовсім

Як позбавиться від «соплів» Гугла

Спосіб, який я опишу нижче, пропонує в своїй статті Антон Черутти - а я лише більш детально розповім про те, як їх видаляти з пошуку Гугла взагалі. Що б відкрити сторінку, в яку потрапили сторінки тільки з основного індексу, потрібно в пошуку Google ввести ось такий рядок:

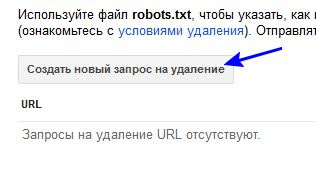

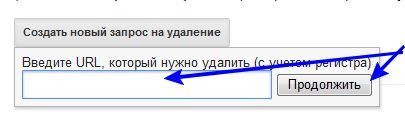

при цьому, зрозуміло, замінивши url мого сайту - на свій або будь-який інший, що цікавить вас. Ці сторінки можна видалити, а потім і заборонити, що б не з'явилися знову, якщо можливо, у файлі Robots.txt.

Для того, що б в подальшому цього не відбувалося, в свій файл я додав рядок, яка забороняє індексацію такого вигляду сторінок: Disallow: * / attachment /

Крім того, я додав на видалення та сторінки, відображені як помилки в гугл-вебмайстрів. Як правило - це помилки 404.

У число помилок входять сторінки, що забороняються мною для індексації у файлі Robots.txt і вони ж потрапляють в «соплі». Ну, тут уже нічого не поробиш. Та й не потрібно нічого робити.

Як позбавиться від дублюючих сторінок з «кракозябрами», індексованими ПС за допомогою FeedBurner

Я давно вже помітив, що одночасно (а то й раніше), в пошуковій системі Яндекс, нові сторінки індексувалися з допомогою мого фида. Для тих, хто запалив цю RSS- стрічку, можливо знайома ситуація, яку так само описав Антон. в результаті чого з'являються дубльовані сторінки (потім вони, на щастя, зникають). Вигляд у цих посилань приблизно такий:

Побачити це можна, якщо відкрити RSS-стрічку і навести курсором на назву статті, в лівому нижньому кутку:

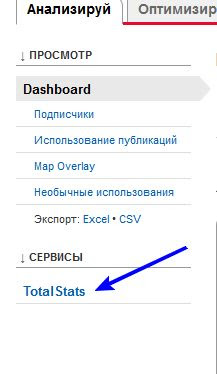

Потрібно виправляти і видаляти дублі. Потрібно! Вступаємо так, як я зобразив на скріншотах нижче. Відкриваємо сторінку редагування фида «Аналізуй», натискаємо по рядку «Total Stats»

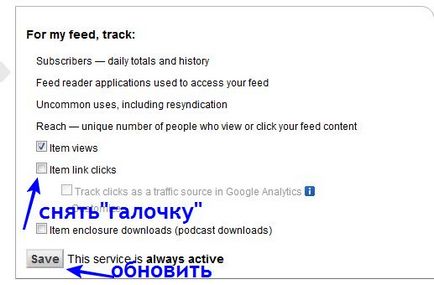

І виконуємо наступні операції:

Тепер можете знову відкрити RSS-стрічку і переконатися: при наведенні курсору на заголовки, посилання відображаються в звичайному. нормальному вигляді.

Отже: прибираємо соплі Google і дублюючі сторінки!

І буде вам щастя. Успіхів!

Коли керівництву потрібно оцінити ефективність роботи співробітників, в хід йдуть будь-які засоби. Насамперед начальство перевірить вашу активність в інтернеті і ...

Традиційно ближче до Нового року Яндекс порадував вебмайстрів новим алгоритмом. І назва у нового алгоритму красиве - «Палех», і штука сама ...

В останні місяці все частіше стали з'являтися матеріали про так званих Push-повідомлення. Незважаючи на те, що цю розробку програмістів вже кілька ...